Physical Address

304 North Cardinal St.

Dorchester Center, MA 02124

Physical Address

304 North Cardinal St.

Dorchester Center, MA 02124

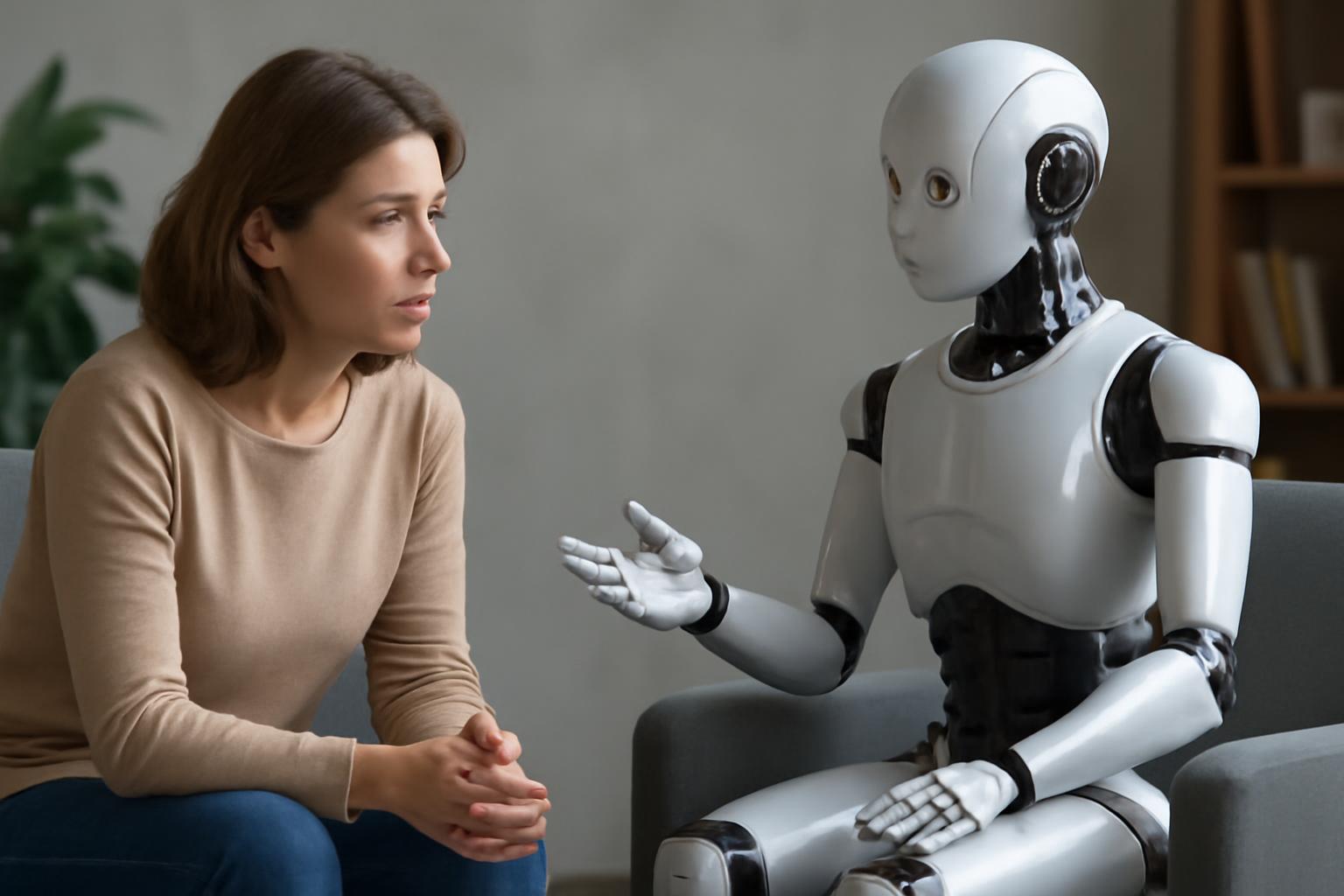

Thérapie avec une IA : découvrez les trois risques méconnus — diagnostic erroné, fuite de données et affaiblissement du lien humain — et comment les éviter.

Thérapie avec une IA : bonne ou mauvaise idée pour votre santé mentale ? Cette question revient partout. Dans cet article, je décrypte pour vous les promesses, les limites et surtout les trois risques que personne n’énonce vraiment. Vous apprendrez à repérer les pièges avant de confier vos confessions à un programme. Attendez-vous à des exemples concrets, des sources fiables et des conseils pratiques pour limiter les dommages.

La technologie parle droit au cœur. Les applications proposent une aide 24/7, des exercices guidés et un prix souvent inférieur à une consultation classique. Pour beaucoup, c’est une porte d’entrée accessible. Les éditeurs vantent l’anonymat, la disponibilité et la traçabilité des progrès. Ces caractéristiques attirent surtout ceux qui hésitent à consulter un professionnel.

Mais la réalité clinique reste complexe. Les émotions humaines ne se réduisent pas toujours à des algorithmes. Les recherches montrent des bénéfices dans certains usages, par exemple pour l’accompagnement des comportements ou la prévention. Pour autant, transformer une conversation intime en données numériques soulève des enjeux éthiques, thérapeutiques et techniques. Je m’appuie ici sur des travaux sérieux et sur des articles de terrain, comme ceux de l’American Psychological Association et de l’Organisation mondiale de la santé, pour donner du contexte et de la nuance. APA Monitor et WHO – santé mentale sont de bons points de départ.

Un programme peut paraître rassurant. Il répond poliment. Il répète des techniques efficaces. Pourtant, il ne possède pas d’intuition clinique. Il ne détecte pas toujours les signaux faibles d’une comorbidité ou d’une crise imminente. Un message trop optimiste peut retarder une prise en charge urgente.

Les algorithmes se basent sur des données historiques. Ils reflètent donc des biais. Ils excellent dans les cas fréquents, et échouent sur les situations atypiques. Quand la machine donne un conseil inadapté, l’utilisateur peut le suivre sans vérification. Ce glissement se paye parfois cher. Le patient croit être aidé. En réalité, il reste sans diagnostic précis.

Vos confidences deviennent des données. Ces dossiers sont précieux. Ils intéressent chercheurs, annonceurs, mais aussi des acteurs moins scrupuleux. Même anonymisées, les informations peuvent parfois être re-identifiées avec des croisements de sources. L’appel à l’analyse de données peut dépasser le cadre thérapeutique.

La promesse d’anonymat est donc fragile. Les politiques de confidentialité sont longues et changeantes. Les fuites existent. Les conséquences vont de la gêne sociale à des préjudices professionnels. Penser que vos échanges restent privés relève souvent d’une fausse sécurité. Mieux vaut lire les conditions et privilégier des services clairement régulés.

La relation entre patient et soignant compte. Elle modère les jugements, soutient la compliance et permet des ajustements subtils. Un logiciel ne remplace pas cette dynamique. Même performant, il peut renforcer l’isolement en donnant l’illusion d’une écoute suffisante.

La répétition d’interactions détachées peut changer la manière dont une personne recherche de l’aide. Certaines finissent par renoncer à une véritable thérapie. D’autres développent une dépendance aux outils numériques. On observe aussi des effets placebo temporaires, puis une rechute. La technologie devrait être un complément, pas un substitut mécanique.

Choisir une solution nécessite de poser trois questions simples. Qui développe l’outil ? Quelles preuves scientifiques soutiennent ses bénéfices ? Quelles garanties de confidentialité existent ? Privilégiez les services évalués par des essais contrôlés et publiés. Vérifiez la présence d’un dispositif d’alerte en cas de crise. Exigez des informations claires sur la gestion des données.

Intégrez la technologie dans un parcours de soins global. La meilleure utilisation se situe souvent en complément d’un thérapeute humain. Les applications peuvent soutenir les exercices entre séances. Elles peuvent aussi faciliter le suivi. Mais elles ne doivent pas remplacer l’évaluation clinique initiale quand les symptômes sont graves.

Enfin, restez exigeant. Demandez la possibilité d’exporter ou de supprimer vos données. Cherchez des labels de sécurité reconnus. Si un service paraît trop parfait, méfiez-vous. La prudence protège mieux que l’enthousiasme naïf.

Pour approfondir, consultez des sources institutionnelles et des revues spécialisées. Elles offrent des synthèses fiables et des recommandations pratiques. L’innovation est prometteuse. Elle mérite d’être encadrée.